Google'da her gün milyarlarca arama yapılıyor ve arama motoru yaklaşık %15 oranında yeni sorgulamayla karşılaşıyor. Elbette bu durum bazen hakikat sonuçların sıralanmasının önünde mani teşkil edebiliyor. Şirket yaptığı açıklamayla, Google'ın artık aramaları daha yeterli anlayacağını açıkladı.

Google'ın arama sonuçları özünde kullanılan lisanı anlayabilmekle ilgili ve arama motoru makine öğrenmesiyle arama tarihinin en büyük atılımını yaptı. Araştırma grubu, dili anlama noktasındaki çalışmalarıyla son beş yılda büyük bir sıçrama sağladı.

Google geçtiğimiz sene “Bidirectional Encoder Representations from Transformers” (BERT) denilen, doğal lisan sürece (NLP) ön eğitimi için açık kaynaklı ve ağ tabanlı bir teknik geliştirdi. Dönüştürücülerden Çift Taraflı Kodlayıcı Teklifleri manasına gelen teknoloji, kullanıcıların en son teknolojiye sahip soru cevaplama sistemini eğitmesini sağlıyor.

BERT modelleri bir sözün tam bağlamını, öncesinde ve sonrasında gelen sözlere bakarak ele alabiliyor. Böylece arama motoru sorgularının gerisindeki maksadı anlayabiliyor.

BERT ile inşa edilebilen modellerden kimileri o kadar karmaşık ki, donanımların da sonlarını zorluyor. Bu yüzden Google arama sonuçlarını daha güzel ve alakalı bilgilerle sunmak için en son Cloud TPU'larını (Bulut Tensör Süreç Birimi) kullanıyor.

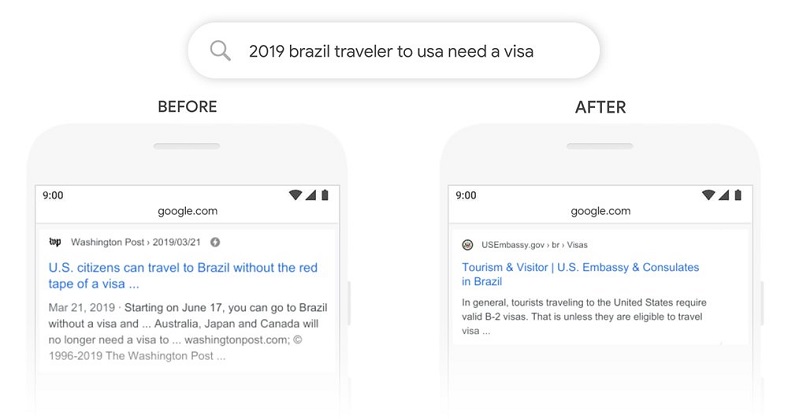

Google verdiği örnekte “2019 Brezilya yolcusu ABD'ye vize alması gerekiyor” formunda bir aramayı ele alıyor. Aslında arama ABD'ye seyahat eden bir Brezilyalı hakkında. Önceden algoritmalar bu ayrımı anlamıyordu ve Brezilya'ya seyahat eden ABD vatandaşları hakkında da sonuçlar veriliyordu. BERT ile arama motoru aradaki farkı anlayabilecek ve ABD”ye” kelimesinin değerli olduğunu saptayarak daha alakalı sonuçlar önerecek.

Google BERT'i tüm dünyadaki beşerler için daha da güzelleştirmeyi hedefliyor. Olay daha evvel de belirttiğimiz üzere dili daha düzgün anlamak. Lakin bu noktada elbette insanların da dengeli aramalar yapmaları gerekiyor. Bakalım Google, arama sonuçlarında ne kadar ileri gidebilecek.